Avantages d’un partenariat avec Communion

• Service intégré, spécialisé dans l’industrie de la « Santé au Naturel »

• Clarification des démarches à prendre pour développer votre entreprise

• Maximiser votre succès en effectuant des choix judicieux en marketing

• Meilleur rendement de vos dépenses marketing

• Augmentation du trafic de nouvelle clientèle

• Achalandage de qualité plus ciblé et hausse des revenus par client.

• Plus grande satisfaction et maintien de la clientèle

• Accroissement des recommandations par votre clientèle à leur entourage

• Simplification des responsabilités du marketing

• Hausse générale des revenus.

Quels sont les avantages à tirer de l'utilisation nos services "clé en main"?

À l'aide d'un plan marketing que nous concevrons ensemble, nous nous assurons de maintenir une cohérence, une continuité et une intégrité entre tous éléments de communication. Contrairement à un infographe qui travaille hors contexte et sans connaissance suffisante de ce domaine, notre équipe saura intégrer les principes et orientation établis dans votre plan marketing de façon intrinsèque. Nos concepteurs sont tous des gens qui sont familiers avec les produits naturels et services de mieux-être; ils connaissent et savent interpréter les images, les symboles, les couleurs, le vocabulaire associés à ces différents mondes.

À l'aide d'un plan marketing que nous concevrons ensemble, nous nous assurons de maintenir une cohérence, une continuité et une intégrité entre tous éléments de communication. Contrairement à un infographe qui travaille hors contexte et sans connaissance suffisante de ce domaine, notre équipe saura intégrer les principes et orientation établis dans votre plan marketing de façon intrinsèque. Nos concepteurs sont tous des gens qui sont familiers avec les produits naturels et services de mieux-être; ils connaissent et savent interpréter les images, les symboles, les couleurs, le vocabulaire associés à ces différents mondes.

Les formats audios expliqués : Partie 2

Formats de numérisation du son

Formats de numérisation du son

CDA (Compact Disc Audio)

Le CDA est le format des pistes des CD audio, tel qu'elles apparaissent lorsqu'elles sont insérées dans le lecteur CD-ROM. Les CD audio du commerce répondent à la norme professionnelle "Red Book". La technique d'échantillonnage du son utilisé pour les disques compacts est la modulation d'impulsion codée (en anglais PCM, pour Pulse Coded Modulation).

Pour le calcul du poids : 44100*2(2octets=16bits)*2(stéréo)*60(secondes)

Le suffixe des fichiers créés est .cda

Pour : Non comprimé, forcément qualité CD

Contre : Volumineux, Pas de gestion de Tag (certains CD sont CD text)

RAW

RAW est un format audio utilisé pour représenter les données de son en modulation d'impulsion codée sans en-tête ni métadonnées.

WAV (Waveform Audio Vector)

Le format WAV mono ou stéréo, mis au point par Microsoft et IBM, est l'un des plus répandus. Le format "Disque compact" 44.1 kHz, 16 bits et stéréo nous servira de référence pour le calcul du poids et ratio des autres formats.

Pour le calcul du poids : 44100*2(2octets=16bits)*2(stéréo)*60(secondes)+ en-têtes = 11 300 kilooctets/minute

Le suffixe des fichiers créés est .wav

Pour : Non comprimé (pour la version PCM)

Contre : Pas de gestion de Tag (certains CD sont CD text), limité à 2 Go

Ogg Vorbis (ou OGG)

Le format Ogg Vorbis est un format libre, fruit de la fondation Xiph.org. Vorbis se différencie des MP3, WMA et autre AAC par son algorithme. Il segmente les sources audio en paquets successifs, l'algorithme de compression agissant dans un premier temps sur chaque paquet indépendamment des autres. Cela lui permet d'avoir très peu de faiblesses sur certaines fréquences et de conserver la même qualité quel que soit le type de musique.

Le suffixe des fichiers créés est .ogg.

Par abus de langage, on appelle 'fichier Ogg' des fichiers musicaux compressés par l'algorithme Vorbis. Ceci peut être particulièrement dérangeant à l'ère des baladeurs numériques supportant audio et vidéo. En fait, Ogg est un conteneur qui peut contenir des pistes sonores (Vorbis), audio sans perte (FLAC), audio parlées (Speex) et vidéo (Theora). Un 'fichier Ogg' peut donc contenir l'un ou l'autre (ou une combinaison) de pistes. Pour être plus clair, nous devrions parler de fichier Ogg Vorbis lorsque nous mentionnons un fichier .ogg qui ne contient qu'une piste sonore au format Vorbis.

Pour : Comprimé, meilleure qualité que le MP3, open source, très bon pour le streaming, supporte 255 canaux

Contre : Long à l'encodage

AIFF (Audio Interchange Format File)

AIFF (Audio Interchange Format File)

L'AIFF est un format de stockage de sons sur les ordinateurs de Apple. C'est l'équivalent du format WAV dans le monde Macintosh.

Les résolutions 8, 16, 20, 24 et 32 bits (à virgule flottante) sont acceptées.

Le suffixe des fichiers créés est .aif

Pour : Non comprimé,

Contre : Très volumineux, une variante l'AIFF-C permet de comprimer la taille jusqu'à 6x.

AAC (Advanced Audio Coding) ou MPEG-2 AAC

L'AAC est une extension du MPEG-2 et a été amélioré en MPEG-4, MPEG-4 Version 2 et MPEG-4 Version 3. Il a été reconnu fin avril 1997.

Il fait partie des successeurs du MP3.

Le suffixe des fichiers créés est .aac, .mp4, .m4a

Pour : Très bon codec destructif (mieux que MP3 et WMA),pas de trous (Gapless), mode 5.1 ou plus .

Contre : Durée d'encodage importante

Apple et l'AAC : Apple l'a choisi comme codec prévilégié, on le retrouve dans son iPod et son logiciel iTunes. Pour la vente musicale en ligne iTunes Music Store, la norme AAC ne proposant pas de système de gestion des droits numériques (DRMs), Apple a développé son propre système, appelé FairPlay. Notons qu'il est lisible sur Mac et PC.

MP3 (MPEG-1 Layer III)

Star incontestée des codecs, MP3 est l'abréviation de MPEG-1 Audio Layer 3. Cet algorithme de compression prend naissance en 1987. L'ISO en fera un standard dans les années 92-93. La couche (Layer) III est la couche la plus complexe. Elle est dédiée à des applications nécessitant des débits faibles d'où une adhésion très rapide du monde internet à ce format de compression. Les taux de compression (ratio) sont d'ordinaire de 1 pour 10 (1:10) (1:4 à 1:12). Très rapide à l'encodage. Des royalties importantes sont à payer pour exploiter la licence (juridique) MP3. Utiliser l'encodeur MP3 LAME dernière version, encodé à 130 kbit/s permet d'obtenir une qualité comparable au AAC (Advanced Audio Coding) encodé à 48 kbit/s. [1]

Le suffixe des fichiers créés est .mp3

Type de compression : constant ou variable (VRB)

Pour : Grande compatibilité, gestion des tag ID3.

Contre : Compression destructive avec problèmes dans les aiguës, lors d'un ré-encodage on passe par un fichier .wav .

mp3PRO

Le format mp3PRO, fruit de la collaboration entre Thomson Multimédia et l'Institut Fraunhofer, combine l'algorithme MP3 et un système améliorant la qualité des fichiers comprimés appelé SBR pour Spectral Bandwidth Replication.

Ce format a été publié à la fin de 2001; un fichier MP3pro 64 kbit/s a le même poids qu'un fichier MP3 à 128 kbit/s pour une qualité similaire.

Le suffixe des fichiers créés est .mp3

Pour : Gain de place.

Contre : Doit obligatoirement être relu avec un lecteur mp3pro. Un fichier 64 kbit/s relu avec un mp3 classique équivaut à un fichier mp3 de 60 kbit/s (coupure à 11 kHz). Moins bon que le mp3 (coupure avant 16kHz). - 64 kbit/s, qualité moyenne due à l’écrasement des pics, moins bon que l'ACC+, le seul encodeur gratuit supportant le MP3 Pro ne code qu'en 64 kbit/s, lors d'un ré-encodage on passe par un fichier .wav . Altération définitive des fichiers codés.

VQF ou TwinVQ (Transform-domain Weighted Interleave Vector Quantization)

VQF ou TwinVQ (Transform-domain Weighted Interleave Vector Quantization)

Le format TwinVQ a été développé par NTT Cyber Space Laboratories et soutenu par Yamaha. Dans le même esprit que le MP3, il comprime encore plus et avec une meilleure qualité. On regrettera une durée d'encodage un peu trop longue, près de 10 fois plus lente que le MP3. De plus, arrivé bien plus tard, et distribué sous une licence très restrictive, il a eu peu d'adeptes et est plus ou moins abandonné.

Le suffixe des fichiers créés est .vqf, .vql ou .vqe

WMA (Windows Media Audio)

Le format WMA, créé par Microsoft à partir des recommandations MPEG-4 en 1999, est utilisé par le logiciel Windows Media Player. Ce format est lié à une gestion pointue des droits d'auteurs (Gestion numérique des droits, en anglais Digital Right Management ou DRM) qui permet de définir par exemple une durée de vie limitée pour les fichiers ou d'interdire les possibilités de gravure.

• Il existe plusieurs versions du codec (wma7.1, wma9, wma pro).

• Le suffixe des fichiers créés est .wma

Pour : bonne compatibilité, gestion des tag, meilleure compression que le MP3.

Contre : Souvent illisible sur lecteurs portables, à cause de la gestion des droits et des restrictions dans le format wma.

AU

Le format AU est assez bien répandu grâce à Unix et Linux. La fréquence d'échantillonnage est comprise entre 1 kHz et 200 kHz. Mais les applications de rendu audio ne lisent principalement que trois fréquences d'échantillonnage: 8012.821 (codec entré), 22050 et 44100 hertz.

• Le suffixe des fichiers créés est .au

• Les résolutions 8, 16, 20, 24 et 32 bits (flottant) sont acceptées.

ASF Advanced Streaming Format

ASF est un format conteneur de Microsoft servant au streaming audio et vidéo.

Contre : Conteneur propriétaire très fermé (Microsoft)

Au delà de la qualité CD

Aujourd'hui, la norme CD a prouvé ses limites, tant au niveau de sa fréquence d'échantillonnage que dans sa définition de 16 bits. Aidé par les nouveaux supports informatiques, le son peut être numérisé en 24 bits, voire 32 bits. La fréquence quant à elle est passée à 96 ou 192 kHz. Cette avancée permet d'avoir un son plus dynamique et plus détaillé dans les transitoires donc d'être plus proche de l'oreille humaine.

Le DVD-Audio est un exemple de qualité supérieure, mais ce type de média ne semble pas attirer le grand public. Sony a également tenté d'imposer son SACD (SuperAudio CD), qui a l'avantage d'exister en version hybride: il est lisible à la fois selon la norme CD Audio classique, sur tous les lecteurs, et en SACD sur un lecteur dédié. Une fois de plus, ce format ne semble pas attirer l'attention du grand public. Le problème ne vient pas donc des solutions, mais du grand public trop conquis par les formats compressés et ne laissant pas de chance aux nouvelles solutions.

Avant la numérisation

Avant la numérisation

Les supports

* Disque compact

* Digital Audio Tape

* Minidisc

* Digital Compact Cassette

* Super Audio CD

* Disque numérique polyvalent (DVD)

* HD-DVD

* Blu-ray Disc

* Carte CF

* Disque dur

Références

1. Å™ (en)Gabriel Bouvigne for MP3'Tech - www.mp3-tech.org, « 48 kbit/s AAC public test », June 2007

L’histoire de la production vidéo expliquée

La vidéo regroupe l'ensemble des techniques, technologie, permettant l'enregistrement ainsi que la restitution d'images animées, accompagnées ou non de son, sur un support adapté à l'électronique et non de type photochimique. Le mot vidéo vient du latin video qui signifie « je vois ». C'est l'apocope de vidéophonie ou vidéogramme. Le substantif vidéo s'accorde en nombre, cependant, l'adjectif reste toujours invariable.

Théorie

Un flux vidéo est composé d'une succession d'images, 25 par seconde en Europe (30 par seconde aux USA), composant l'illusion du mouvement. Chaque image est décomposée en lignes horizontales, chaque ligne pouvant être considérée comme une succession de points. La lecture et la restitution d'une image s'effectue donc séquentiellement ligne par ligne comme un texte écrit : de gauche à droite puis de haut en bas.

Entrelacement

Entrelacement

L'image d'un téléviseur est une succession de balayages horizontaux, de gauche à droite, partant du haut, et finissant en bas de l'écran. Au commencement de la télévision, la qualité des éléments phosphorescents du tube est fort médiocre. De ce fait, quand le faisceau balaye le bas de l'écran, le haut a déjà disparu, d'où un phénomène de scintillement, ressenti fortement par l'œil humain pour 25 Hz ou 30 Hz. La solution la plus simple eût été d'accélérer la cadence de balayage, mais ceci imposait également d'augmenter la cadence des images, ce qui était inutile d'un point de vue cinématographique (le mouvement est perçu de la même façon), et fort coûteux en matériel et en bande passante. Une solution plus astucieuse fut de doubler la cadence de balayage, en omettant une ligne sur deux, afin de garder une quantité d'information constante. Ainsi, une première passe affiche toutes les lignes impaires en deux fois moins de temps que pour une image entière et une seconde passe affiche les lignes manquantes paires : c'est ce que l'on appelle l'entrelacement. On obtient bien le même nombre de lignes de balayages pour une image, et on balaye deux fois l'écran pour afficher une seule image. On désigne par le terme « trame » ("field" en anglais) une passe de balayage. Une image est donc constituée de deux trames, puisqu'il faut deux balayages pour définir l'image ("frame" en anglais).

Les caméras, qui fonctionnent comme un « téléviseur inversé », adoptèrent elles aussi cet entrelacement du balayage. Dans la première moitié du temps d'une image, une 1re prise de vue définit toutes les lignes impaires, et une moitié d'image plus tard, une seconde prise de vue définit les lignes paires. Ce qu'il faut bien comprendre ici, c'est que les deux prises de vues sont distantes dans le temps (d'une moitié d'image). Et même si ces deux prises de vue sont complémentaires d'un point de vue spatial (les deux balayages se complètent dans le cadre), ces deux prises de vue n'affichent pas le même contenu ! Si un sujet se déplace dans le champ, il aura une position différente sur chacune des deux trames : on a alors un effet de zig-zag sur chaque frame.

Ce problème est en partie résolu par un dispositif de lames cristallines biréfringentes qui "étalent" les détails en dédoublant les rayons lumineux. Il en découle une perte de définition qui confèrent aux système PAL et SECAM une résolution verticale multipliée par 0,7 (facteur de Kell) et qui n'est plus réellement que de 400 lignes environ.

Du fait de la capture en deux trames de 1/50 de seconde chacune, c'est le temps de pose en vidéo (25i).

Il existe dorénavant de plus en plus d'appareils vidéo capables d'afficher 25, 50 ou 60 images complètes par seconde, l'affichage n'est plus entrelacé, on parle alors de balayage progressif. Parmi les appareils capables d'un tel affichage on trouve : les ordinateurs (leur carte vidéo et leur écran), certains vidéoprojecteurs, les téléviseurs haut de gamme, certaines platines DVD et quelques rares caméscopes. C'est le mode de capture choisi pour les films tournés en HDTV ou en D-cinéma destinés à être transférés et projetés en 35 mm.

Les 25 images progressives (25p) confèrent alors aux caméras un temps de pose de 1/25 de seconde ce qui est trop long en terme de résolution temporelle. On préfère alors limiter le temps d'intégration des trames à 1/50 s (obturateur électronique).

Capture de l'image

Capture de l'image

Les premières caméras vidéo, fonctionnant sur le même principe que les téléviseurs, analysaient l'image formée par l'objectif à l'aide d'un tube cathodique. Depuis la fin des années 1980, elles sont dotées de capteurs Charge-Coupled Device : CCD ou Dispositif à Transfert de Charges (DTC) en français.

Le transfert de ces charges peut se faire de 3 manières différentes : transfert interligne (capteur IT : Inteline Transfer), transfert trame (capteur FT : Frame Transfer) qui nécessite un obturateur mécanique et est rarement utilisé ou transfert FIT (Frame Interline Transfer).

Au début du XXIe siècle, les fabricants de capteurs ont décidé d'abandonner cette technologie et construisent désormais des capteurs CMOS (Complementary Metal Oxide Semi-conductor). On trouve cependant encore sur le marché des camescopes semi-professionnels utilisant la technologie dite "tri-CCD" qui permet d'améliorer notablement le traitement des couleurs.

Résolution de l'image et fréquence de balayage

Il existe différents formats d'image vidéo, qui dépendent essentiellement de la fréquence de balayage vertical de l'image :

* 405 lignes 50 Hz (standard anglais abandonné) noir et blanc

* 525 lignes 60 Hz : résolution 4/3 utile = 711 x 480 (standard américain) couleur NTSC et PAL-N

* 625 lignes 50 Hz : résolution 4/3 utile = 702 x 576 (standard européen) couleur PAL, SECAM et NTSC-4.43

* 819 lignes 50 Hz : résolution 4/3 utile = 1024 x 768 (standard français abandonné) noir et blanc

On peut constater à ce point qu'il existe une différence entre le nombre de lignes composant l'image et le nombre de lignes affichées. Ceci représente une différence de 49 lignes en 50 Hz et de 45 lignes en 60 Hz. Ces lignes perdues sont nécessaires, elles représentent le temps nécessaire pour que le faisceau d'électrons balayant le tube cathodique puisse remonter du bas de l'image vers le haut. Ce problème technique n'existe pas avec les panneaux LCD et les dalles plasma, mais il est conservé pour assurer la compatibilité. Les lignes libres sont mises partiellement à profit : on y place les signaux du télétexte, du sous-titrage et aussi le time-code des équipements vidéo professionnels.

Il faut distinguer deux fréquences de balayage de l’image :

* Le balayage vertical, qui s'effectue de haut en bas et sert à composer l'image. Il s'effectue 50 ou 60 fois par seconde.

* Le balayage horizontal, qui s'effectue de droite à gauche pour chaque ligne de l'image. La fréquence de balayage horizontal est donc égale à la fréquence verticale multipliée par le nombre de lignes et divisée par deux à cause de l'entrelacement.

F_h = \frac{F_v N}{2}

Ce qui donne les valeurs suivantes :

* Fh(50Hz) = 50 x 625 / 2 = 15625 Hz

* Fh(60Hz) = 60 x 525 / 2 = 15750 Hz

Ce résultat n'est pas du au hasard. Si les fréquences horizontales sont presque les mêmes en 50Hz et en 60 Hz, c'est que cela permet d'utiliser la même circuiterie de balayage horizontal, donc de réaliser des économies.

Couleur

Depuis quelques décennies on connaissait les particularités spectrales de l'œil humain, qui affichaient une très nette préférence pour certaines couleurs. De plus on savait que le spectre chromatique de l'œil peut se décomposer en trois couleurs primaires, qui permettent par mélange de recréer à peu près toutes les autres couleurs du spectre. Le cinéma couleur exploitait ceci en utilisant des émulsions à plusieurs couches, dont chacune était sensible à une couleur donnée.

Les ingénieurs vidéo optèrent pour trois couleurs bien particulières : rouge vert bleu. Ces couleurs sont dites primaires (à ne pas confondre avec les couleurs primaires du domaine de la peinture qui sont le bleu, le rouge et le jaune) car ce sont elles qui, par mélange, vont permettre de recomposer un spectre entier de couleurs.

La prise de vue en couleur s'effectue selon un prisme optique qui répartit la lumière sur trois capteurs, devant lesquels on a respectivement un filtre rouge, vert et bleu. Ainsi, chaque capteur n'enregistre que les informations de lumière concernant sa couleur. Il suffit ensuite d'enregistrer puis restituer les 3 composantes RVB (RGB en anglais) sur un moniteur couleur acceptant les trois entrées RVB. Il faut bien comprendre que l'on obtient trois signaux à la place d'un seul. Il faut non seulement tripler toutes les liaisons câblées entre les différents équipements, mais aussi tripler les pistes d'enregistrement sur un magnétoscope, tripler tous les équipements de production, jusqu'aux équipements de diffusion hertzienne... Le défi était donc de créer un signal unique englobant trois informations différentes, et qui ne devaient pas se mélanger avant le traitement par le poste de réception.

Le défi était aussi de conserver la totale compatibilité avec les postes noir et blanc encore très présents dans les foyers. On travailla donc dans le but de créer un signal vidéo englobant : du rouge, du vert, du bleu, et du noir et blanc dans le même tuyau, sans que ceux-ci se mélangent.

Pour commencer, il était impensable d'avoir une caméra noir et blanc ET une caméra couleur. Il fallait donc fabriquer du noir et blanc à partir des trois composantes RVB. Se basant sur les sensibilités de l'œil aux différentes couleurs, on prit 59 % de vert, 30 % de rouge, et 11 % de bleu qu'on mélangea copieusement. On venait d'inventer un nouveau terme : la luminance (Y). Les télés noir et blanc pourraient donc voir en noir et blanc des images issues de caméra couleur. Comment maintenant rajouter à ce Y les informations de couleurs nous permettant de retrouver notre RVB original ? Puisqu'on avait déjà la lumière de notre image (le Y), il fallait « colorier » ce noir et blanc avec des informations de couleurs qui ne contenaient elles, aucune valeur de lumière, mais uniquement des indications de teinte et de saturation.

Une fois d'accord pour ce noir et blanc colorisé, il fallut trouver l'astuce qui permettrait de transmettre la lumière (Y) et la chroma (que nous appellerons C pour faire simple). Des procédés électroniques aux noms aussi effrayants que « modulation d'amplitude en quadrature de phase, à sous-porteuse supprimée » virent le jour. Ces solutions se devaient à la fois de mixer 2 signaux de manière à pouvoir les discriminer à la réception, mais aussi de n'avoir aucune interférence visible dans le spectre du signal noir et blanc.

Ces solutions furent trouvées et appliquées. Ainsi sont nés le NTSC (National Television System Committee) aux États-Unis, le SECAM (SÉquentiel Couleur À Mémoire) en France, et le PAL (Phase Alternate Line) en Allemagne. La technique employée pour transformer du RVB en signal couleur compatible noir et blanc s'appelle le codage. Le NTSC, le SECAM et le PAL sont trois types de codages différents, et bien entendu, incompatibles entre eux. Passer d'un type de codage à un autre s'appelle transcodage.

Aucune des trois solutions n'est néanmoins transparente, loin s'en faut. Un signal codé souffre d'artefacts plus ou moins visibles selon le codage.

Un signal vidéo codé de la sorte est dit signal composite, car il contient plusieurs sources de nature différente. Les standards vidéo utilisant le composite vont de l'U-MATIC / U-MATIC SP au VHS en passant par le 8mm ou Video 8, le Betamax, le VCR ou encore le V2000. Au vu des dégradations causées par le codage, il devenait urgent de s'en absoudre en production.

Au début des années 80, SONY mit au point un format vidéo à composantes séparées, constitué de plusieurs signaux distincts, véhiculés par des câbles distincts : le Betacam / Betacam SP. Pour rester compatible N&B, on évita soigneusement le RVB, et on choisit naturellement un format comportant le fameux Y (signal N&B), plus des informations de chrominance véhiculées par 2 signaux : U & V (appelés aussi Cr et Cb). Pour ceux qui n'auraient pas encore décroché, le U = R - Y, le V = B - Y, où Y = 0,30R+0,59V+0,11B (les coefficients étant différents selon le codage utilisé). Cette transformation de RVB en YUV s'appelle Matriçage. Contrairement au codage, le matriçage est une opération très simple, qui ne génère pas de dégradation, tout en offrant l'avantage de la compatibilité Y.

Quelques années plus tard, on vit apparaître un format grand public dit S-Video ou Y/C, où la luminance Y et la chrominance C (codée en NTSC, PAL ou SECAM) étaient séparées (S-VHS, Hi-8, Super-Betamax). Ce format est de qualité meilleure qu'un format composite, puisque la chrominance n'empiète plus sur la bande de fréquences de la luminance, ce qui pouvait amener à des artefacts colorés sur des détails fins. La résolution horizontale de ces formats pouvait donc être quasiment doublée (400 points/ligne au lieu de 240-250).

La vidéo numérique

Introduction

L’histoire du numérique dans la vidéo commence véritablement de 1972 à 1982. À l’origine équipements de synchronisation, les appareils se sophistiquèrent avant d’entrer dans le milieu professionnel. Dès lors, les industriels prirent conscience de l’avènement de ce nouveau phénomène et présentèrent des normes en matière de numérisation. Une certaine anarchie numérique régna alors sur le marché ce qui força la main au CCIR (Comité consultatif international de radiodiffusion) à normaliser un format vidéo en composantes numériques compatible dans le monde entier : cette norme c'est le 4:2:2, ou CCIR 601. Elle spécifie les paramètres de codage de signaux à numériser (échantillonnage, quantification…) Dès lors les innovations ne cessèrent de s’enchaîner pour permettre aujourd'hui, à la vidéo numérique, de se généraliser dans les centres de production, chaînes TV et régie de post-production pour assister le montage vidéo.

La photographie expliquée : Partie 2

La photographie astronomique

La photographie astronomique

Astrophotographie. Technique qui est utilisée en astronomie, qui consiste à photographier des astres.

Les usages de la photographie

Dès son invention, l'usage de la photographie est intimement lié à l'évolution de sa technique. Elle est ainsi devenue le premier art réellement populaire.

Une technique objective

La photographie inaugure une nouvelle ère dans la représentation : on est à présent capable d'avoir une représentation du réel « objective ». C'est-à-dire que l'homme ne représente plus le réel tel qu'il le voit et tel qu'il le peut mais c'est le réel qui impressionne, « seul », le support. Ainsi la photographie trouve rapidement son usage dans le reportage, dans l'anthropométrie, inventée par Alphonse Bertillon. On a l'ambition de réaliser un inventaire du monde.

Nous savons toutefois aujourd'hui que cette objectivité a ses limites. Déjà la photographie argentique permettait de travestir la réalité, d'ajouter ou de retrancher des éléments d'une image par un patient travail de laboratoire. Mais avec l'avènement de la photographie numérique, ces trucages qui n'étaient auparavant accessibles qu'à des connaisseurs, deviennent presque à la portée de tous. De plus, est-on réellement capable de représenter le monde objectivement, puisque chacun en a une vision qui lui est propre ?

Influence sur la peinture

Jusqu’à l'usage de la photographie, c'est la peinture qui avait pour rôle la représentation de la réalité. Les peintres étaient tiraillés entre le besoin d'une représentation fidèle à la réalité et le désir d'embellir leurs tableaux pour les rendre plus attrayants. Avec l'arrivée de la photo, les arts plastiques ont pu se libérer de la réalité et se tourner vers l'art abstrait.

La photographie a aussi inauguré une époque où presque tout le monde pouvait disposer de son portrait ou de représentations d'objets ou de lieux qui restaient jusque-là réservés à une élite économique, quand il fallait demander à un peintre de réaliser une image. Cela s'est traduit dans un premier temps par certaines photographies qui s'approchaient beaucoup du portrait peint le plus classique.

Mais la réalisation de la photographie s'est également rapidement diffusée. Et aujourd'hui, presque tout le monde a facilement accès à la capacité de « prendre une photo ». La représentation du monde en a été transformée et les sociologues ne manquent pas d'étudier les pratiques et les résultats de cette photographie populaire. Pensons seulement aux touristes japonais, l'appareil photographique toujours en bandoulière, ou à nos boîtes à chaussures pleines de vieilles photographies de famille.

Mais la réalisation de la photographie s'est également rapidement diffusée. Et aujourd'hui, presque tout le monde a facilement accès à la capacité de « prendre une photo ». La représentation du monde en a été transformée et les sociologues ne manquent pas d'étudier les pratiques et les résultats de cette photographie populaire. Pensons seulement aux touristes japonais, l'appareil photographique toujours en bandoulière, ou à nos boîtes à chaussures pleines de vieilles photographies de famille.

Cet environnement très favorable permet ainsi de parler d’« art populaire » par la possibilité ainsi offerte au plus grand public de posséder les formes de cet art et d'en produire les artefacts.

Le sixième art

La photographie est un moyen technique et mécanique de conserver une représentation graphique des moments, des objets ou des gens. Mais c'est aussi un moyen d'expression plus ou moins abstrait, portant la signature de son auteur, le photographe, et dont l'objectivité est équivalente à n'importe quelle œuvre artistique. Longtemps enfermée dans l'imitation de la peinture (pictorialisme, marines, portraits...), la photographie a trouvé sa propre voie artistique avec l'apparition du surréalisme...

Citations

* Robert Capa : « Si ta photographie n'est pas bonne, c'est que tu n’étais pas assez près. »

* David Burnett : « Capa disait que si la photo n'est pas bonne, c'est qu'on n'est pas assez près. Moi, je pense que si la photo n'est pas bonne, c'est qu'on est trop près. La distance permet d'élargir le point de vue. »

* Wilfrid Estève : « Faire disparaître les traces de positions politiques du reportage revient à faire un contresens absolu sur sa nature même. C'est désincarner le rêve et la révolte. »

* Pierre Movila : « Une photographie, c'est un arrêt du cœur d'une fraction de seconde. »

* John Stuart Mill : « La photographie est une brève complicité entre la prévoyance et le hasard. »

* Jules Renard : « Que de gens ont voulu se suicider et se sont contentés de déchirer leur photographie ! »

* Edgar Watson Howe : « Une théorie ne ressemble pas plus à un fait qu'une photographie ne ressemble à son modèle. »

* Marcel Proust : « La photographie acquiert un peu de la dignité qui lui manque, quand elle cesse d'être une reproduction du réel et nous montre des choses qui n'existent plus. »

* Andréa-Lisa Bolduc : « Photographier c'est captiver un moment éternellement. »

* Ditsie:«Briser une photo c'est détruire un moment.»

Festivals

Festivals

Catégorie dédiée : Musée ou galerie photographique

* Visa pour l'image, festival international du photojournalisme de Perpignan

* Rencontres internationales de la photographie d'Arles

* Festival international de la photo animalière et de nature de Montier-en-Der

* Le festival Images', à Vevey

* Le Festival Photobis

* Le Mois de la Photo, Montréal, Québec, Canada

* Rencontres de l'Imagerie Nature, Fournels, France

* Rencontres photographiques de Bamako

Notes et références

1. Å™ (fr) Définitions lexicographiques et étymologiques de photographie du CNRTL.

2. Å™ (fr) Canon reste leader du marché des appareils photo numérique - Le Monde informatique, 04 avril 2007

Bibliographie

* Olivia Colo, Wilfrid Estève et Mat Jacob, "Photojournalisme, à la croisée des chemins", mention spéciale du jury du prix Nadar en 2005, co-édition EMI-CFD/Marval.

* Hubert Damisch, La dénivelée - À l'épreuve de la photographie, Éditions du Seuil.

* Jean-Clet Martin, Le corps de l'empreinte, Éditions Kimé.

* Pierre Bourdieu, Un art moyen, essai sur les usages sociaux de la photographie, Éditions de Minuit.

* Roland Barthes, "La chambre claire" Gallimard

* Gisèle Freund, "Photographie et société"

* Susan Sontag, "Sur la photographie", Editions Christian Bourgois.

Infographie

Nos services

Matériel promotionnel et publicitaire

• Concevoir votre matériel promotionnel et publicitaire; planifier et acheter de l’espace médiatique dans les médias imprimés et électroniques.

• Créer et produire tout ce qui est imprimé, plastifié, laminé, gravé, sculpté, moulé (papier, métal, bois, vinyle ou autres).

• Concevoir et produire vos cartes d’affaires, dépliants, livres, vitrines, affiches, pancartes et placards ainsi que la signalisation intérieure et extérieure de votre immeuble.

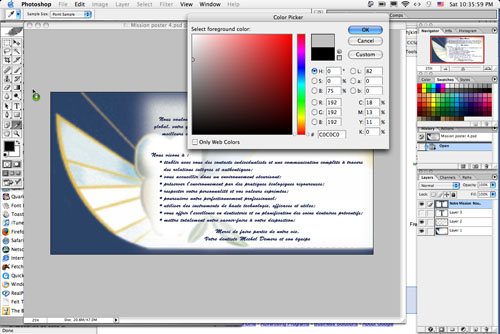

L’infographie expliquée

L'infographie désigne les graphismes créés et gérés par ordinateur, dont la gestion se base sur une station graphique composée d'éléments matériels comme le processeur et la carte graphique dont les puissances déterminent la vitesse de réponse et de calcul des unités graphiques, les outils d'acquisition comme le numériseur ou la caméra banc-titre, les outils de manipulation comme la souris ou la tablette graphique, les outils de stockage comme le disque-dur ou la clé-USB et les outils de restitution comme l'imprimante ou le moniteur d'ordinateur, d'une interface utilisateur qui permet l'interaction entre l'utilisateur et l'ordinateur et enfin du format de données qui assure l'intermédiaire entre l'image rendue et les éléments numériques de celle-ci.

L'infographie désigne les graphismes créés et gérés par ordinateur, dont la gestion se base sur une station graphique composée d'éléments matériels comme le processeur et la carte graphique dont les puissances déterminent la vitesse de réponse et de calcul des unités graphiques, les outils d'acquisition comme le numériseur ou la caméra banc-titre, les outils de manipulation comme la souris ou la tablette graphique, les outils de stockage comme le disque-dur ou la clé-USB et les outils de restitution comme l'imprimante ou le moniteur d'ordinateur, d'une interface utilisateur qui permet l'interaction entre l'utilisateur et l'ordinateur et enfin du format de données qui assure l'intermédiaire entre l'image rendue et les éléments numériques de celle-ci.

Lors de l'introduction du concept dans la langue française vers les années 1980, elle désigne uniquement les graphismes, qu'on appelle alors « infographies » (information par le graphisme), destinés à mettre en image des informations généralement statiques au moyen de diagrammes, de cartes ou de schémas. Mais le concept d'infographie s'étant rapidement élargi à tous les graphismes produits par des moyens informatiques, on la distingue par le terme d'« infographie de presse », domaine où les infographies sont les plus utilisées.[1] Cette activité est liée aux arts graphiques par les personnes qui l'appréhendent comme une forme d'expression artistique.

Sommaire

* 1 Infographiste

* 2 Histoire

* 3 Pratique

* 4 Bibliographie

Infographiste

L’infographiste - metteur en page prépare et réalise des supports de communication visuelle (dessins, graphismes, illustrations, montages). Ce métier combine l’art du graphisme à l’utilisation de l’outil informatique et des logiciels adaptés pour un travail en 2D et en 3D . Il assemble et met en page des médias (images + textes) sur écran d’ordinateur à partir d’une maquette, soit pour l’édition et l’imprimerie (brochures, dépliants, plaquettes, catalogues..) soit pour la publication en réseaux (pages web, documents électroniques). L’infographiste est amené à collaborer étroitement avec d’autres professionnels : directeur artistique, photographe, scénariste, animateur 3D, architecte, imprimeur, webmaster, programmeur,et créateur de graphisme.

L’infographiste - metteur en page prépare et réalise des supports de communication visuelle (dessins, graphismes, illustrations, montages). Ce métier combine l’art du graphisme à l’utilisation de l’outil informatique et des logiciels adaptés pour un travail en 2D et en 3D . Il assemble et met en page des médias (images + textes) sur écran d’ordinateur à partir d’une maquette, soit pour l’édition et l’imprimerie (brochures, dépliants, plaquettes, catalogues..) soit pour la publication en réseaux (pages web, documents électroniques). L’infographiste est amené à collaborer étroitement avec d’autres professionnels : directeur artistique, photographe, scénariste, animateur 3D, architecte, imprimeur, webmaster, programmeur,et créateur de graphisme.

Histoire

On mentionne depuis 1973 (IBM Systems Journal), et à intervalles irréguliers depuis, la création expérimentale d'hologrammes par ordinateur. Mais cette opération étant lente et donc non-interactive (pour le moment), elle n'a pas bouleversé la profession.

Au tout début de lère numérique, les graphistes étaient souvent des autodidactes. Et ces « talents » étaient très demandés. Maintenant, pour devenir infographiste, il faut avoir une solide formation en graphisme, et une bonne connaissance des outils graphiques sur ordinateur.

La quasi-généralisation de l'outil informatique dans le domaine du graphisme, au cours des années 1990, rend un peu artificielle la distinction entre « graphiste » et « infographiste », tous les graphistes étant plus ou moins des infographistes.

Pratique

Les termes généraux pour désigner un pratiquant de l'infographie est « infographiste » ou « infographe ». Dans le domaine du journalisme, on utilise « infographiste de presse », « rédacteur graphiste », « éditeur graphiste » ou « illustrateur infographiste » selon l'activité journalistique et/ou graphique de la personne au sein de l'équipe de rédaction. Dans les arts graphiques, on distingue principalement ceux qui manipulent des images en deux dimensions de ceux qui manipulent des objets dans un espace en trois dimensions.

Les termes généraux pour désigner un pratiquant de l'infographie est « infographiste » ou « infographe ». Dans le domaine du journalisme, on utilise « infographiste de presse », « rédacteur graphiste », « éditeur graphiste » ou « illustrateur infographiste » selon l'activité journalistique et/ou graphique de la personne au sein de l'équipe de rédaction. Dans les arts graphiques, on distingue principalement ceux qui manipulent des images en deux dimensions de ceux qui manipulent des objets dans un espace en trois dimensions.

On retrouve la première approche principalement dans la bande-dessinée où la mise en couleur, voire l'encrage sont effectués au moyen de logiciels de dessin assisté par ordinateur, dans la publicité où la retouche d'images est omniprésente, dans les jeux vidéo où le pixel-art fut prédominant jusqu'à la cinquième génération de consoles lorsque la 2D migre vers les textures.

On retrouve la 3D principalement dans l'architecture où on utilise les modeleurs 3D pour préfigurer l'apparence d'un bâtiment dont on prévoit ou promeut la construction, dans les films d'animation publicitaires ou cinématiques où la puissance fournie par les solutions 3D est exploitée au maximum ou encore dans les jeux vidéo où les phases de jeu actives en 3D sont limitées à la 3D polygonale et optimisées au maximum pour pallier les limitations matérielles qui ne permettraient pas le temps réel le cas échéant.

Parmi les outils d'acquisition, on peut citer le crayon optique, la palette graphique, le numériseur de document, la souris, la tablette graphique ou encore le trackball. Les outils de restitution les plus courants sont l'imprimante et le moniteur d'ordinateur.

Bibliographie

Béatrice Poinssac, L'infographie, Presses Universitaires de France - Que sais-je ?, Paris, 1994 (ISBN 2130457940).

Conception Multimédia

Nos services

Nous offrons un service de conception et de gestion de projet pour la création de produits ou d'outil de communication éducatifs ou promotionnels incluant les présentations PowerPoint, logiciels et conception de DVD ou de CD interactif.

Production Audio

Nos services

• Enregistrement audio de conférence pour CD, DVD et Internet.

• Montage audio

• Effets spéciaux

• Création de bande sonore incluant musique originale pour tout média

• Enregistrement de conférence téléphonique.

• Numérisation, compression pour Internet

• Conversion de formats

Les formats audios expliqués

Un format audio est un format de données utilisé en informatique pour représenter des sons, de la musique ou des voix sous forme numérique. De nombreux standards existent; certains s'appliquent mieux que d'autres au stockage de types particuliers de signaux audio.

Sommaire

* 1 Caractéristiques des formats audio

* 2 Formats de numérisation du son

o 2.1 CDA (Compact Disc Audio)

o 2.2 RAW

o 2.3 WAV (Waveform Audio Vector)

o 2.4 Ogg Vorbis (ou OGG)

o 2.5 AIFF (Audio Interchange Format File)

o 2.6 AAC (Advanced Audio Coding) ou MPEG-2 AAC

o 2.7 MP3 (MPEG-1 Layer III)

o 2.8 mp3PRO

o 2.9 VQF ou TwinVQ (Transform-domain Weighted Interleave Vector Quantization)

o 2.10 WMA (Windows Media Audio)

o 2.11 AU

o 2.12 ASF Advanced Streaming Format

* 3 Choix de la norme pour l'archivage d'un enregistrement

* 4 Choix de la norme pour la diffusion d'un enregistrement

o 4.1 Norme appliquée à un support

o 4.2 Norme appliquée au streaming

* 5 Au delà de la qualité CD

* 6 Avant la numérisation

* 7 Les supports

* 8 Références

* 9 Voir aussi

o 9.1 Liens internes

o 9.2 Liens externes

Caractéristiques des formats audio

Chaque format audio présente des caractéristiques découlant de l'algorithme de compression/décompression, ou codec, qu'il utilise. Après la numérisation du son, le format utilisé est inscrit dans l'extension du fichier de données qui en stocke la transcription.

Dans un format donné, les fichiers sont déclinés en plusieurs taux de compression ou format de données (codées sur 8, 16 ou 24 bits) avec différentes fréquences d'échantillonage (22.05, 44.1 ou 48 kilohertz), qui induisent des niveaux de qualité sonore et des poids de fichier très différents. De manière générale, pour un codec donné, plus le taux de compression est bas, moins le fichier est comprimé mais plus la qualité du fichier comprimé s'approche de la celle du fichier non comprimé. Par contre, plus le taux de compression est haut, plus le rendu sonore perd de sa qualité.

Les formats audios expliqués : Partie 2 >>>

Production Vidéo

Nos services

Nous offrons une gamme complète de services vidéo pour les vidéos d’éducation, formation et documentaires :

• Tournage de conférence, de stage ou de formation

• Vidéo cours de yoga, tai chi, pilates, mise en forme, etc.

• Formation à distance par Internet

• Concert de musique ‘nouvel âge’ et ‘musique du monde’

• Montage post-production • Effets spéciaux

• Animation 3D

• Traduction (sous-titre ou narration)

• Trame sonore original sur mesure

Nos Spécialités

A) Promotion

A) Promotion

Pour expliquer ou pour vendre vos services ou produits surs : a) Votre site Web b) YouTube, Viméo et autres c) mettre sur réseaux sociaux.

Méthode très rentable pour rejoindre des personnes intéressées à travers le monde.

Voici un exemple de vidéo produit par notre entreprise :

https://www.youtube.com/watch?v=znL8qECW1HY

B) Instruction conviviale d'utilisation de votre site

Comment utiliser les fonctionnalités sur votre site Web, soit pour vos employés, soit pour les clients et visiteurs

Exemple ; sur un de nos sites

http://www.starinspiration.com/video/video/search?q=Fran%C3%A7ais+Intruction

C) Formation par Vidéo

- Pour formation à distance ou surplace.

- Peu se diffuser ou se télécharger par internet.

Voir la section vidéo pour certains examples de nos productions >>>

Contactez-nous pour en discuter ou pour une soumission gratuite >>>

Photographie

Nos services

Nous vous offrons un service de photographie de haute qualité adaptable à tous les budgets. Notre connaisance du domaine ‘Santé au naturel’ nous permet de suggèrer des orientations artistes appropriées et attirantes. La photographie expliquée

Sommaire

Sommaire

• Étymologie La photographie numérique

• La photographie astronomique

• Les usages de la photographie

• Une technique objective ?

• Influence sur la peinture

• Un art populaire

• Le sixième art

• Citations

• Les grands photographes

• Festivals

• Notes et références

• Bibliographie

Étymologie

Le terme photographie a un sens triple[1] :

1. C'est la technique qui permet de créer des images par l'action de la lumière.

2. C'est une image obtenue par cette technique.

3. Plus généralement, c'est la branche des arts graphiques qui utilise cette technique.

La photographie numérique

Les techniques informatiques permettent de transformer une image en une série de points, les pixels, dont les caractéristiques sont exprimées par des nombres, ce qui permet de la reconstruire sur un périphérique informatique. La difficulté de cette technologie, qui marque une rupture complète avec les procédés physico-chimiques initiaux, se situe dans la conception des capteurs électroniques de l'image qui remplacent le film. La résolution de ces capteurs, le nombre de pixels d'une image qu'ils sont capables d'analyser, évolue très rapidement. Sur les appareils commercialisés, ils atteignent en 2007 jusqu’à dix millions de pixels pour les appareils au capteur APS et trente-neuf millions de pixels pour les moyens formats et permettent d'obtenir une image de qualité pour une taille d'environ un demi-mètre carré. Comme pour les anciennes techniques, cette qualité dépend aussi de l'optique de l'objectif et de la mécanique du boîtier.

La photographie numérique présente l'avantage des possibilités infinies de retraitement et de retouche des images avec un ordinateur et un logiciel de traitement d'image. De la simple correction de lumière, de contraste, à la composition d'image, les usages peuvent être artistiques et ouvrir ainsi une liberté de création ou mercantiles quand il s'agit de modeler un idéal féminin publicitaire.

La photographie numérique présente l'avantage des possibilités infinies de retraitement et de retouche des images avec un ordinateur et un logiciel de traitement d'image. De la simple correction de lumière, de contraste, à la composition d'image, les usages peuvent être artistiques et ouvrir ainsi une liberté de création ou mercantiles quand il s'agit de modeler un idéal féminin publicitaire.

Les réseaux de communication, internet, et les services communautaires de photo en ligne apparus depuis 2003, ont déployés les possibilités d'usage de la photo numérique. Avec les blogs et les services de partage de photographies comme Pikeo ou Flickr, les photographes internautes disposent des outils et services permettant la communication, l'échange, l'exposition de leurs photos numériques, autant dans la sphère privée, communautaire, qu'à l'échelle planétaire. Les services offrent des possibilités d'exploitation en ligne considérables : gestion des contacts, diaporamas, localisation géographique...). Les artistes et professionnels y trouvent leur compte avec des audiences considérables pouvant dépasser n'importe quel lieu d'exposition physique.

Les grandes marques d'appareils photo numériques sont : Canon, Kodak, Leica, Nikon, Olympus, Panasonic, Pentax, Sony... Le marché est actuellement dominé par Canon (18,7 %) et Sony (15,8 %) [2]

La photographie expliquée : Partie 2 >>>